微信高并发资金交易系统设计方案——百亿红包背后的技术支撑 数据处理与存储服务

在微信红包这一现象级业务的背后,是每秒百万级交易请求、百亿级别资金流转的极端挑战。支撑这一海量高并发资金交易系统的核心,正是其精心设计的数据处理与存储服务体系。本文将深入剖析这一体系的关键技术方案与设计哲学。

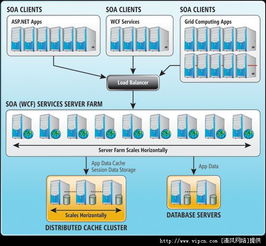

一、架构总览:分层解耦与弹性扩展

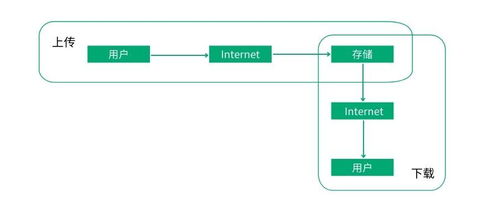

微信资金交易系统的数据处理与存储服务采用典型的分层架构,核心思想是“解耦”与“弹性”。系统自上而下分为接入层、逻辑层、数据层与持久化层。接入层负责海量请求的接入、协议转换与负载均衡;逻辑层(无状态服务集群)处理核心交易逻辑,如红包的创建、抢夺、入账;数据层提供高性能、强一致性的内存数据访问,作为系统的“高速缓存”与“状态中枢”;持久化层则确保所有交易记录最终安全落盘。各层之间通过轻量级RPC或消息队列通信,允许独立水平扩展,这是应对流量洪峰的根本保障。

二、数据层的核心:定制化内存数据库与强一致性保障

面对红包“抢”这一瞬间超高并发写场景,传统数据库难以招架。微信团队自主研发了高性能内存数据库,作为数据处理的核心引擎。其关键设计包括:

- 分片与路由:红包ID等关键业务字段被用于数据分片(Sharding),将海量请求分散到数百个数据节点上,实现并行处理。

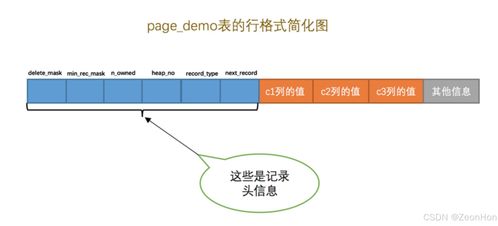

- 单线程模型与无锁设计:每个数据分片由单个线程处理所有请求,避免了多线程锁竞争,极大提升了性能。数据结构的精心设计(如使用CAS操作)确保了在并发下的正确性。

- 强一致性协议:采用类似Raft的共识算法,在内存数据库节点间实现多副本强一致性。任何一个红包的金额扣减、状态变更,都必须在多数副本上达成一致后才返回成功,绝不允许超发或资金不一致,这是金融系统的生命线。

三、持久化存储:异步化、批量化与最终一致性

内存虽快,但易失。所有交易记录必须持久化存储。系统采用“异步流水线”方式:

- Write-Ahead Logging (WAL):任何内存数据变更首先顺序追加写入高可靠的WAL(如分布式文件系统),即使机器宕机,也能据此恢复内存状态,保证数据不丢失。

- 异步归档至OLTP数据库:内存中的交易记录会被异步、批量地归档到后端的关系型数据库集群(如MySQL)。通过合并写入、顺序提交等优化,极大降低了数据库的写入压力。

- 冷热数据分离与OLAP分析:海量历史交易数据会进一步归档到大数据平台(如Hadoop/Hive)或NoSQL数据库,支持离线对账、风控分析和业务报表,形成完整的“在线-离线”数据链路。

四、数据处理流水线:实时计算与流式处理

除了基础的存取,系统还需实时处理交易数据以支持风控、监控和用户实时反馈。为此,构建了基于流式计算引擎(如Storm/Flink)的数据处理流水线:

- 实时交易流水订阅:所有成功交易会实时发布到消息队列(如Kafka)。

- 流式处理:流计算任务实时消费这些流水,进行多维度的聚合计算,如:用户维度(今日已抢金额)、红包维度(已被抢比例)、全局维度(当前TPS)。

- 实时输出:计算结果实时写入高速KV存储(如Redis),供前端接口查询(如红包详情页显示“已抢X/X个”);同时触发实时风控规则,如识别异常抢包行为。

五、容灾与高可用:多活数据中心与智能调度

为保障服务永续,数据处理与存储服务部署在多个地理分布的数据中心,形成“同城双活+异地灾备”的格局。通过全局流量调度(GTM)和分布式配置中心,在单个数据中心故障时,能秒级将用户流量切换至健康机房。数据层通过跨机房的数据同步(在可接受的延迟内),确保业务连续性。

六、总结

微信百亿红包背后的数据处理与存储服务体系,是一套融合了高性能内存计算、分布式一致性、异步流水线、流式实时处理与多活高可用技术的复杂综合体。其设计精髓在于:将最核心、最热的数据置于极致优化的内存处理中以保证性能;通过可靠的异步机制保障数据的最终持久化与一致性;并构建全链路的实时数据处理能力以赋能业务。这套方案不仅支撑了红包场景,也为微信支付乃至整个行业的高并发金融级系统提供了宝贵的技术范本。

如若转载,请注明出处:http://www.zhaocebao.com/product/30.html

更新时间:2026-03-02 19:00:27